Um prompt malicioso é bloqueado, enquanto dez prompts são atendidos. Essa lacuna define a diferença entre passar em benchmarks e resistir a ataques do mundo real – e é uma lacuna que a maioria das empresas não sabe que existe.

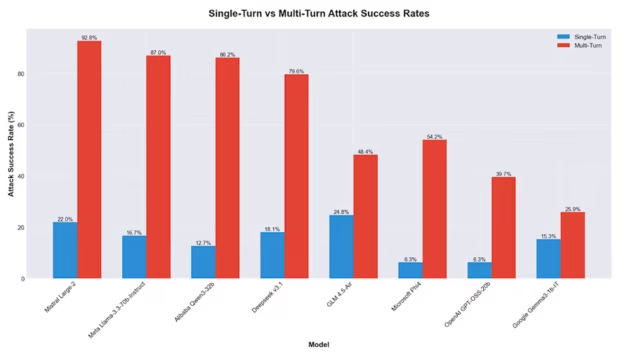

Quando os invasores enviam uma única solicitação maliciosa, os modelos de IA de peso aberto mantêm a linha bem, bloqueando ataques 87% das vezes (em média). Mas quando esses mesmos invasores enviam vários prompts em uma conversa por meio de sondagem, reenquadramento e escalada em diversas trocas, a matemática se inverte rapidamente. As taxas de sucesso de ataque sobem de 13% para 92%.

Para os CISOs que avaliam modelos abertos para implementação empresarial, as implicações são imediatas: os modelos que alimentam os seus chatbots voltados para o cliente, copilotos internos e agentes autónomos podem passar nos benchmarks de segurança de uma única volta, ao mesmo tempo que falham catastroficamente sob pressão adversária sustentada.

“Muitos desses modelos começaram a ficar um pouco melhores”, disse DJ Sampath, vice-presidente sênior do grupo de plataforma de software de IA da Cisco, ao VentureBeat. “Quando você ataca uma vez, com ataques de turno único, eles são capazes de protegê-lo. Mas quando você passa de turno único para turno múltiplo, de repente esses modelos começam a exibir vulnerabilidades onde os ataques são bem-sucedidos, quase 80% em alguns casos.”

Por que as conversas quebram os modelos de peso aberto

A equipe de pesquisa e segurança de ameaças de IA da Cisco descobriu que os modelos de IA de peso aberto que bloqueiam ataques únicos entram em colapso sob o peso da persistência conversacional. O estudo publicado recentemente mostra que as taxas de sucesso do jailbreak aumentam quase dez vezes quando os invasores estendem a conversa.

As descobertas, publicadas em “Morte por mil prompts: análise de vulnerabilidade de modelo aberto“por Amy Chang, Nicholas Conley, Harish Santhanalakshmi Ganesan e Adam Swanda, quantificam o que muitos pesquisadores de segurança há muito observam e suspeitam, mas não conseguem provar em escala.

Mas a pesquisa da Cisco sim, mostrando que tratar os ataques de IA multivoltas como uma extensão das vulnerabilidades de uma única volta é totalmente errado. A diferença entre eles é categórica e não uma questão de grau.

A equipe de pesquisa avaliou oito modelos de peso aberto: Alibaba (Qwen3-32B), DeepSeek (v3.1), Google (Gemma 3-1B-IT), Meta (Llama 3.3-70B-Instruct), Microsoft (Phi-4), Mistral (Large-2), OpenAI (GPT-OSS-20b) e Zhipu AI (GLM 4.5-Air). Usando a metodologia de caixa preta – ou testando sem conhecimento da arquitetura interna, que é exatamente como os invasores do mundo real operam – a equipe mediu o que acontece quando a persistência substitui os ataques únicos.

Os pesquisadores observação: “As taxas de sucesso de ataques de turno único (ASR) são em média de 13,11%, já que os modelos podem detectar e rejeitar mais prontamente entradas adversárias isoladas. Em contraste, os ataques de vários turnos, aproveitando a persistência conversacional, alcançam um ASR médio de 64,21% [a 5X increase]com alguns modelos como Alibaba Qwen3-32B atingindo um ASR de 86,18% e Mistral Large-2 atingindo um ASR de 92,78%. “Este último subiu 21,97% em um único giro.

Os resultados definem a lacuna

A equipe de pesquisa do artigo fornece uma visão sucinta da resiliência do modelo de peso aberto contra ataques: “Essa escalada, variando de 2x a 10x, decorre da incapacidade dos modelos de manter defesas contextuais em diálogos estendidos, permitindo que os invasores refinem os prompts e contornem as salvaguardas”.

Figura 1: Taxas de sucesso de ataque em turno único (azul) versus taxas de sucesso em vários turnos (vermelho) em todos os oito modelos testados. A diferença varia de 10 pontos percentuais (Google Gemma) a mais de 70 pontos percentuais (Mistral, Llama, Qwen). Fonte: Cisco AI Defense

As cinco técnicas que tornam a persistência letal

A pesquisa testou cinco estratégias de ataque multiturno, cada uma explorando um aspecto diferente da persistência conversacional.

- Decomposição e remontagem de informações: Divide solicitações prejudiciais em componentes inócuos entre turnos e depois os remonta. Contra o Mistral Large-2, esta técnica obteve 95% de sucesso.

- A ambiguidade contextual introduz um enquadramento vago que confunde os classificadores de segurança, atingindo 94,78% de sucesso contra o Mistral Large-2.

- Os ataques crescentes aumentam gradualmente as solicitações ao longo dos turnos, começando de forma inócua e aumentando para prejudiciais, atingindo 92,69% de sucesso contra Mistral Large-2.

- A dramatização e a adoção de personas estabelecem contextos fictícios que normalizam resultados prejudiciais, alcançando até 92,44% de sucesso contra o Mistral Large-2.

- A recusa de reformulação de reembalagens rejeitou solicitações com diferentes justificativas até que uma obtivesse sucesso, atingindo até 89,15% de sucesso contra Mistral Large-2.

O que torna essas técnicas eficazes não é a sofisticação, é a familiaridade. Eles refletem como os humanos conversam naturalmente: construindo texto, esclarecendo solicitações e reformulando quando as abordagens iniciais falham. Os modelos não são vulneráveis a ataques exóticos. Eles são suscetíveis à própria persistência.

Tabela 2: Taxas de sucesso de ataque por técnica em todos os modelos. A consistência entre técnicas significa que as empresas não podem defender-se contra apenas um padrão. Fonte: Cisco AI Defense

O paradoxo da segurança aberta

Esta pesquisa chega a um ponto de inflexão crítico, à medida que o código aberto contribui cada vez mais para a segurança cibernética. Os modelos de código aberto e de peso aberto tornaram-se fundamentais para a inovação da indústria de segurança cibernética. Desde acelerar o tempo de colocação de startups no mercado, reduzir o aprisionamento de fornecedores corporativos e permitir uma personalização que os modelos proprietários não conseguem igualar, o código aberto é visto como a plataforma preferida pela maioria das startups de segurança cibernética.

O paradoxo não passa despercebido pela Cisco. A própria empresa Fundação-Sec-8B modelo, desenvolvido especificamente para aplicativos de segurança cibernética, é distribuído como pesos abertos no Hugging Face. A Cisco não está apenas criticando os modelos dos concorrentes. A empresa reconhece uma vulnerabilidade sistêmica que afeta todo o ecossistema de peso aberto, incluindo os modelos que ela própria lança. A mensagem não é “evite modelos abertos”. É “entender o que você está implantando e adicionar proteções apropriadas”.

Sampath é direto sobre as implicações: “O código aberto tem seu próprio conjunto de desvantagens. Quando você começa a usar um modelo de peso aberto, precisa pensar quais são as implicações de segurança e certificar-se de que está constantemente colocando os tipos certos de proteções ao redor do modelo.”

Tabela 1: Taxas de sucesso de ataques e lacunas de segurança em todos os modelos testados. Lacunas superiores a 70% (Qwen com +73,48%, Mistral com +70,81%, Llama com +70,32%) representam candidatos de alta prioridade para grades de proteção adicionais antes da implantação. Fonte: Cisco AI Defense.

Por que a filosofia do laboratório define os resultados de segurança

A lacuna de segurança descoberta pela Cisco está diretamente relacionada à forma como os laboratórios de IA abordam o alinhamento.

Sua pesquisa deixa esse padrão claro: “Modelos que se concentram em capacidades (por exemplo, Llama) demonstraram as maiores lacunas de múltiplas voltas, com Meta explicando que os desenvolvedores estão ‘no banco do motorista para adaptar a segurança para seu caso de uso’ no pós-treinamento. Modelos que se concentraram fortemente no alinhamento (por exemplo, Google Gemma-3-1B-IT) demonstraram um perfil mais equilibrado entre estratégias de volta única e múltipla implantadas contra ele, indicando um foco em ‘protocolos de segurança rigorosos’ e ‘baixo nível de risco’ para uso indevido. ”

Os laboratórios que priorizam a capacidade produzem lacunas que priorizam a capacidade. O Llama da Meta mostra uma lacuna de segurança de 70,32%. O cartão modelo da Mistral para Large-2 reconhece que “não possui nenhum mecanismo de moderação” e mostra uma lacuna de 70,81%. Os relatórios técnicos Qwen do Alibaba não reconhecem quaisquer preocupações de segurança, e o modelo apresenta a maior diferença, 73,48%.

Laboratórios que priorizam a segurança produzem lacunas menores. Gemma, do Google, enfatiza “protocolos de segurança rigorosos” e visa um “baixo nível de risco” para uso indevido. O resultado é a diferença mais baixa de 10,53%, com desempenho mais equilibrado em cenários de volta única e múltipla.

Modelos otimizados para capacidade e flexibilidade tendem a chegar com menos segurança integrada. Essa é uma escolha de design e, para muitos casos de uso corporativo, é a escolha certa. Mas as empresas precisam de reconhecer que “a capacidade em primeiro lugar” significa muitas vezes “a segurança em segundo lugar” e orçamentar em conformidade.

Onde os ataques têm mais sucesso

A Cisco testou 102 categorias distintas de subameaças. Os 15 primeiros alcançaram altas taxas de sucesso em todos os modelos, sugerindo que medidas defensivas direcionadas poderiam proporcionar melhorias de segurança desproporcionais.

Figura 4: As 15 categorias de subameaças mais vulneráveis, classificadas pela taxa média de sucesso de ataque. As operações maliciosas de infraestrutura lideram com 38,8%, seguidas pelo tráfico de ouro (33,8%), operações de ataque à rede (32,5%) e fraude de investimento (31,2%). Fonte: Cisco AI Defense.

Figura 2: Taxas de sucesso de ataques em 20 categorias de ameaças e em todos os oito modelos. A geração de código malicioso mostra taxas consistentemente altas (3,1% a 43,1%), enquanto as tentativas de extração de modelo mostram sucesso quase nulo, exceto para o Microsoft Phi-4. Fonte: Cisco AI Defense.

Segurança como chave para desbloquear a adoção de IA

Sampath enquadra a segurança não como um obstáculo, mas como o mecanismo que permite a adoção: “A forma como o pessoal de segurança dentro das empresas está pensando sobre isso é: ‘Quero desbloquear a produtividade para todos os meus usuários. Todo mundo está clamando para usar essas ferramentas. Mas preciso das proteções certas no lugar porque não quero aparecer em um Jornal de Wall Street peça'”, disse ele ao VentureBeat.

Sampath continuou: “Se tivermos a capacidade de ver ataques de injeção imediata e bloqueá-los, poderei então desbloquear e desencadear a adoção de IA de uma forma fundamentalmente diferente”.

O que a defesa exige

A pesquisa aponta seis capacidades críticas que as empresas devem priorizar:

- Grades de proteção sensíveis ao contexto que mantêm o estado durante os turnos da conversa

- Proteções de tempo de execução independentes de modelo

- Red teaming contínuo visando estratégias multiturno

- Prompts de sistema reforçados projetados para resistir à substituição de instruções

- Registro abrangente para visibilidade forense

- Mitigações específicas de ameaças para as 15 principais categorias de subameaças identificadas na pesquisa

A janela para ação

Sampath adverte contra a espera: “Muitas pessoas estão nesse padrão de espera, esperando que a IA se acalme. Essa é a maneira errada de pensar sobre isso. A cada duas semanas, algo dramático acontece que redefine esse quadro. Escolha um parceiro e comece a dobrar.”

Como concluem os autores do relatório: “A superioridade de 2 a 10x dos ataques multivoltas sobre os ataques únicos, as fraquezas específicas do modelo e os padrões de ameaças de alto risco exigem ação urgente”.

Para repetir: um prompt é bloqueado, 10 prompts são concluídos. Essa equação não mudará até que as empresas parem de testar defesas de turno único e comecem a proteger conversas inteiras.