Startup chinesa de inteligência artificial DeepSeek lançou dois novos modelos de IA poderosos no domingo que a empresa afirma corresponder ou exceder as capacidades do OpenAI GPT-5 e do Google Gêmeos-3.0-Pro — um desenvolvimento que poderá remodelar o cenário competitivo entre os gigantes tecnológicos americanos e os seus adversários chineses.

A empresa sediada em Hangzhou lançou DeepSeek-V3.2projetado como um assistente de raciocínio diário, junto com DeepSeek-V3.2-Speciale, uma variante de alta potência que alcançou desempenho com medalha de ouro em quatro competições internacionais de elite: a Olimpíada Internacional de Matemática de 2025, a Olimpíada Internacional de Informática, as Finais Mundiais do ICPC e a Olimpíada de Matemática da China.

O lançamento traz implicações profundas para a liderança tecnológica americana. A DeepSeek demonstrou mais uma vez que pode produzir sistemas de IA de fronteira, apesar dos controles de exportação dos EUA que restringir o acesso da China a chips avançados da Nvidia – e fê-lo ao disponibilizar gratuitamente os seus modelos sob uma licença de código aberto do MIT.

“As pessoas pensaram que o DeepSeek deu um avanço único, mas voltamos muito maiores”, escreveu Chen Fangque se identificou como colaborador do projeto, no X (antigo Twitter). O lançamento gerou reações rápidas online, com um usuário declarando: “Descanse em paz, ChatGPT.”

Como o avanço da escassa atenção do DeepSeek reduz os custos de computação

No coração do novo lançamento está Atenção escassa do DeepSeekou DSA — uma inovação arquitetônica que reduz drasticamente a carga computacional da execução de modelos de IA em documentos longos e tarefas complexas.

Os mecanismos tradicionais de atenção da IA, a tecnologia central que permite aos modelos de linguagem compreender o contexto, são mal dimensionados à medida que o comprimento da entrada aumenta. Processar um documento com o dobro do tempo normalmente requer quatro vezes mais cálculo. A abordagem da DeepSeek quebra essa restrição usando o que a empresa chama de “indexador relâmpago” que identifica apenas as partes mais relevantes do contexto para cada consulta, ignorando o resto.

De acordo com Relatório técnico do DeepSeeko DSA reduz os custos de inferência em aproximadamente metade em comparação com modelos anteriores ao processar sequências longas. A arquitetura “reduz substancialmente a complexidade computacional enquanto preserva o desempenho do modelo”, afirma o relatório.

O processamento de 128.000 tokens – aproximadamente o equivalente a um livro de 300 páginas – agora custa aproximadamente US$ 0,70 por milhão de tokens para decodificação, em comparação com US$ 2,40 do processo anterior. Modelo V3.1-Terminal. Isso representa uma redução de 70% nos custos de inferência.

Os modelos de 685 bilhões de parâmetros suportam janelas de contexto de 128.000 tokens, tornando-os adequados para analisar documentos extensos, bases de código e artigos de pesquisa. DeepSeek relatório técnico observa que avaliações independentes em benchmarks de longo contexto mostram que o desempenho da V3.2 está no mesmo nível ou melhor que seu antecessor, “apesar de incorporar um mecanismo de atenção esparso”.

Os resultados do benchmark que colocam o DeepSeek na mesma liga do GPT-5

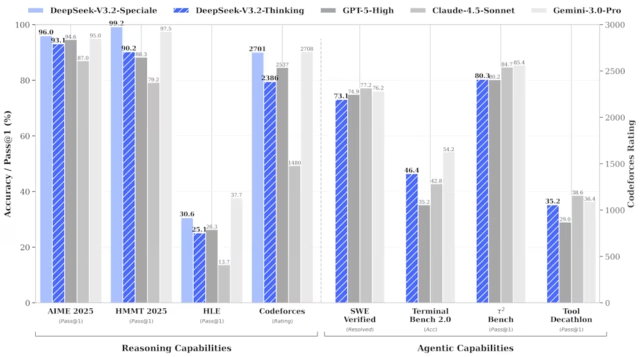

As reivindicações de paridade da DeepSeek com os principais sistemas de IA da América baseiam-se em testes extensivos em tarefas de matemática, codificação e raciocínio – e os números são impressionantes.

Sobre AIME 2025uma prestigiada competição americana de matemática, DeepSeek-V3.2-Especial alcançou uma taxa de aprovação de 96,0%, em comparação com 94,6% para GPT-5-High e 95,0% para Gemini-3.0-Pro. No Torneio de Matemática Harvard-MITa variante Speciale obteve 99,2%, superando os 97,5% do Gemini.

O padrão Modelo V3.2otimizado para uso diário, obteve pontuação de 93,1% no AIME e 92,5% no HMMT – modelos marginalmente abaixo da fronteira, mas alcançado com substancialmente menos recursos computacionais.

O mais impressionante são os resultados da competição. DeepSeek-V3.2-Especial marcou 35 de 42 pontos no Olimpíada Internacional de Matemática de 2025ganhando status de medalha de ouro. No Olimpíada Internacional de Informáticamarcou 492 de 600 pontos – também ouro, ficando em 10º lugar geral. O modelo resolveu 10 dos 12 problemas no Finais Mundiais do ICPCficando em segundo lugar.

Esses resultados vieram sem acesso à Internet ou ferramentas durante os testes. O relatório da DeepSeek afirma que “o teste segue estritamente o tempo e os limites de tentativa do concurso”.

Em benchmarks de codificação, DeepSeek-V3.2 resolveu 73,1% dos bugs de software do mundo real em Verificado pelo SWEcompetitivo com GPT-5-High em 74,9%. Sobre Banco Terminal 2.0medindo fluxos de trabalho de codificação complexos, o DeepSeek obteve pontuação de 46,4% – bem acima dos 35,2% do GPT-5-High.

A empresa reconhece limitações. “A eficiência do token continua a ser um desafio”, afirma o relatório técnico, observando que o DeepSeek “normalmente requer trajetórias de geração mais longas” para corresponder à qualidade de saída do Gemini-3.0-Pro.

Por que ensinar a IA a pensar enquanto usa ferramentas muda tudo

Além do raciocínio bruto, DeepSeek-V3.2 introduz o “pensamento no uso de ferramentas” – a capacidade de raciocinar através de problemas enquanto simultaneamente executa código, pesquisa na web e manipula arquivos.

Os modelos anteriores de IA enfrentavam uma limitação frustrante: cada vez que chamavam uma ferramenta externa, perdiam a linha de pensamento e tinham que reiniciar o raciocínio do zero. A arquitetura do DeepSeek preserva o rastreamento de raciocínio em várias chamadas de ferramentas, permitindo a solução fluida de problemas em várias etapas.

Para treinar essa capacidade, a empresa construiu um enorme pipeline de dados sintéticos, gerando mais de 1.800 ambientes de tarefas distintos e 85.000 instruções complexas. Isso incluiu desafios como planejamento de viagens de vários dias com restrições orçamentárias, correções de bugs de software em oito linguagens de programação e pesquisas baseadas na web que exigem dezenas de pesquisas.

O relatório técnico descreve um exemplo: planejar uma viagem de três dias saindo de Hangzhou com restrições de preços de hotéis, classificações de restaurantes e custos de atrações que variam de acordo com as opções de acomodação. Essas tarefas são “difíceis de resolver, mas fáceis de verificar”, tornando-as ideais para treinar agentes de IA.

DeepSeek empregou ferramentas do mundo real durante o treinamento – APIs reais de pesquisa na web, ambientes de codificação e notebooks Jupyter – enquanto gerava prompts sintéticos para garantir a diversidade. O resultado é um modelo que se generaliza para ferramentas e ambientes invisíveis, um recurso crítico para implantação no mundo real.

A aposta de código aberto da DeepSeek pode derrubar o modelo de negócios da indústria de IA

Ao contrário da OpenAI e da Anthropic, que protegem seus modelos mais poderosos como ativos proprietários, a DeepSeek lançou ambos V3.2 e V3.2-Especial sob a licença do MIT — uma das estruturas de código aberto mais permissivas disponíveis.

Qualquer desenvolvedor, pesquisador ou empresa pode baixar, modificar e implantar os modelos de 685 bilhões de parâmetros sem restrições. Pesos completos do modelo, código de treinamento e documentação são disponível em Hugging Facea plataforma líder para compartilhamento de modelos de IA.

As implicações estratégicas são significativas. Ao disponibilizar gratuitamente modelos com capacidade de fronteira, o DeepSeek prejudica os concorrentes que cobram preços premium de API. O cartão modelo Hugging Face observa que DeepSeek forneceu scripts Python e casos de teste “demonstrando como codificar mensagens em formato compatível com OpenAI” – tornando a migração de serviços concorrentes simples.

Para clientes empresariais, a proposta de valor é atraente: desempenho de ponta a custos drasticamente mais baixos, com flexibilidade de implantação. Mas as preocupações com a residência de dados e a incerteza regulatória podem limitar a adoção em aplicações sensíveis – especialmente dadas as origens chinesas do DeepSeek.

Muros regulatórios estão se erguendo contra o DeepSeek na Europa e na América

A expansão global da DeepSeek enfrenta resistência crescente. Em junho, a comissária de proteção de dados de Berlim, Meike Kamp, declarou que a transferência de dados de usuários alemães da DeepSeek para a China é “ilegal“de acordo com as regras da UE, pedindo à Apple e ao Google que considerem o bloqueio do aplicativo.

A autoridade alemã manifestou preocupação pelo facto de “as autoridades chinesas terem amplos direitos de acesso a dados pessoais dentro da esfera de influência das empresas chinesas”. A Itália ordenou que o DeepSeek bloquear seu aplicativo em fevereiro. Os legisladores dos EUA mudaram-se para proibir o serviço de dispositivos governamentais, citando preocupações de segurança nacional.

Também persistem dúvidas sobre os controlos de exportação dos EUA concebidos para limitar as capacidades de IA da China. Em agosto, DeepSeek deu a entender que a China em breve teria “próxima geração“chips fabricados internamente para suportar seus modelos. A empresa indicou que seus sistemas funcionam com chips fabricados na China Huawei e Cambricão sem configuração adicional.

O modelo V3 original do DeepSeek foi supostamente treinado em cerca de 2.000 versões mais antigas Chips Nvidia H800 – hardware desde então restrito para exportação para a China. A empresa não revelou o que impulsionou o treinamento V3.2, mas seu avanço contínuo sugere que os controles de exportação por si só não podem impedir o progresso da IA chinesa.

O que o lançamento do DeepSeek significa para o futuro da competição de IA

O lançamento chega em um momento crucial. Após anos de investimentos massivos, alguns analistas questionam se está se formando uma bolha de IA. A capacidade da DeepSeek de corresponder aos modelos de fronteira americanos por uma fração do custo desafia as suposições de que a liderança em IA exige enormes gastos de capital.

A empresa relatório técnico revela que o investimento pós-formação ultrapassa agora 10% dos custos pré-formação — uma dotação substancial creditada a melhorias de raciocínio. Mas o DeepSeek reconhece lacunas: “A amplitude do conhecimento mundial no DeepSeek-V3.2 ainda está atrás dos principais modelos proprietários”, afirma o relatório. A empresa planeja resolver isso dimensionando a computação pré-treinamento.

DeepSeek-V3.2-Especial permanece disponível por meio de uma API temporária até 15 de dezembro, quando seus recursos serão incorporados à versão padrão. A variante Speciale foi projetada exclusivamente para raciocínio profundo e não suporta chamada de ferramenta – uma limitação que o modelo padrão aborda.

Por enquanto, a corrida pela IA entre os Estados Unidos e a China entrou numa nova fase. O lançamento da DeepSeek demonstra que os modelos de código aberto podem atingir um desempenho de vanguarda, que as inovações de eficiência podem reduzir drasticamente os custos e que os sistemas de IA mais poderosos poderão em breve estar disponíveis gratuitamente para qualquer pessoa com uma ligação à Internet.

Como observou um comentarista do X: “Deepseek quebrar casualmente os benchmarks históricos estabelecidos por Gemini é uma loucura”.

A questão já não é se a IA chinesa pode competir com Silicon Valley. A questão é saber se as empresas americanas conseguirão manter a liderança quando o seu rival chinês oferecer gratuitamente tecnologia comparável.