A memória dos agentes continua sendo um problema que as empresas desejam resolver, pois os agentes esquecem algumas instruções ou conversas à medida que demoram.

Antrópico acredita ter resolvido esse problema para seus Claude Agente SDKdesenvolvendo uma solução dupla que permite que um agente trabalhe em diferentes janelas de contexto.

“O principal desafio dos agentes de longa duração é que eles devem trabalhar em sessões distintas, e cada nova sessão começa sem nenhuma memória do que aconteceu antes”, escreveu a Anthropic em uma postagem no blog. “Como as janelas de contexto são limitadas e a maioria dos projetos complexos não podem ser concluídos em uma única janela, os agentes precisam de uma maneira de preencher a lacuna entre as sessões de codificação.”

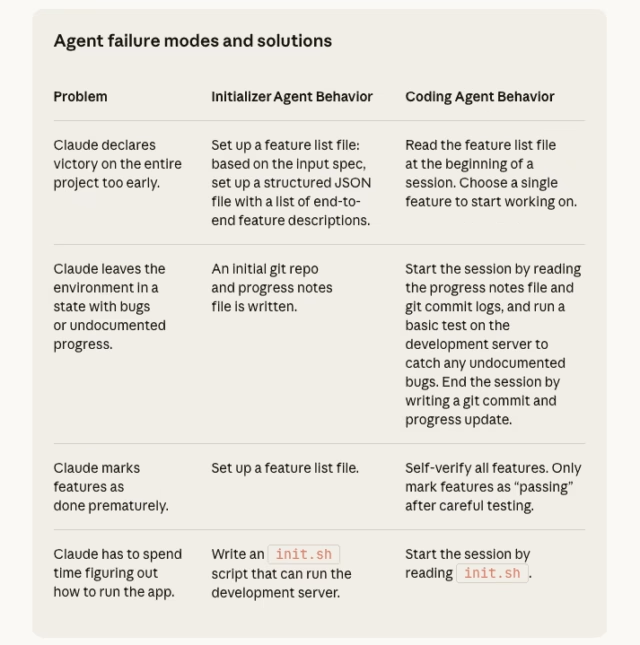

Os engenheiros da Anthropic propuseram uma abordagem dupla para seu Agent SDK: um agente inicializador para configurar o ambiente e um agente de codificação para fazer progresso incremental em cada sessão e deixar artefatos para a próxima.

O problema de memória do agente

Como os agentes são construídos sobre modelos básicos, eles permanecem limitados pelas janelas de contexto limitadas, embora em constante crescimento. Para agentes de longa duração, isso poderia criar um problema maior, levando o agente a esquecer instruções e a se comportar de maneira anormal durante a execução de uma tarefa. Aprimorando a memória do agente torna-se essencial para um desempenho consistente e seguro para os negócios.

Vários métodos surgiram no ano passado, todos tentando preencher a lacuna entre as janelas de contexto e a memória do agente. LangChainSDK do LangMem, Base de memorandos e OpenAISwarm da Swarm são exemplos de empresas que oferecem soluções de memória. A pesquisa sobre memória agente também explodiu recentemente, com propostas estruturas como Memp e o Paradigma de aprendizagem aninhado de Google oferecendo novas alternativas para melhorar a memória.

Muitas das estruturas de memória atuais são de código aberto e podem se adaptar idealmente a diferentes modelos de linguagem grande (LLMs) que alimentam agentes. A abordagem da Anthropic melhora seu Claude Agent SDK.

Como funciona

A Anthropic identificou que, embora o Claude Agent SDK tivesse recursos de gerenciamento de contexto e “devesse ser possível para um agente continuar a fazer um trabalho útil por um tempo arbitrariamente longo”, ele não era suficiente. A empresa disse em seu blog que um modelo como o Opus 4.5 executar o Claude Agent SDK pode “não conseguir construir um aplicativo da web com qualidade de produção se receber apenas um prompt de alto nível, como ‘construir um clone de Claude.ai’”.

As falhas se manifestaram em dois padrões, disse a Anthropic. Primeiro, o agente tentou fazer demais, fazendo com que o modelo ficasse fora de contexto no meio. O agente então tem que adivinhar o que aconteceu e não pode passar instruções claras ao próximo agente. A segunda falha ocorre mais tarde, após alguns recursos já terem sido construídos. O agente vê que o progresso foi feito e apenas declara o trabalho concluído.

Os pesquisadores da Antrópicos quebraram a solução: configurar um ambiente inicial para estabelecer as bases para os recursos e estimular cada agente a fazer progressos incrementais em direção a uma meta, ao mesmo tempo em que deixa uma lousa em branco no final.

É aqui que entra a solução de duas partes do agente da Anthropic. O agente inicializador configura o ambiente, registrando o que os agentes fizeram e quais arquivos foram adicionados. O agente de codificação solicitará então que os modelos façam progressos incrementais e deixem atualizações estruturadas.

“A inspiração para essas práticas veio de saber o que engenheiros de software eficazes fazem todos os dias”, disse Anthropic.

Os pesquisadores disseram que adicionaram ferramentas de teste ao agente de codificação, melhorando sua capacidade de identificar e corrigir bugs que não eram óbvios apenas no código.

Pesquisa futura

A Anthropic observou que sua abordagem é “um conjunto possível de soluções em um conjunto de agentes de longa duração”. No entanto, esta é apenas a fase inicial do que poderá tornar-se uma área de investigação mais ampla para muitos no espaço da IA.

A empresa disse que seus experimentos para aumentar a memória de longo prazo para agentes não mostraram se um único agente de codificação de uso geral funciona melhor em contextos ou em uma estrutura multiagente.

Sua demonstração também se concentrou no desenvolvimento de aplicativos web full-stack, portanto, outros experimentos devem se concentrar na generalização dos resultados em diferentes tarefas.

“É provável que algumas ou todas essas lições possam ser aplicadas aos tipos de tarefas de agente de longa duração exigidas, por exemplo, em pesquisa científica ou modelagem financeira”, disse a Anthropic.