Pesquisadores da Universidade de Ciência e Tecnologia da China desenvolveram uma nova estrutura de aprendizagem por reforço (RL) que ajuda a treinar grandes modelos de linguagem (LLMs) para tarefas ativas complexas além de problemas bem definidos, como matemática e codificação.

Seu quadro, Agente-R1é compatível com algoritmos RL populares e mostra melhorias consideráveis em tarefas de raciocínio que requerem vários estágios de recuperação e interações multivoltas com ferramentas.

A estrutura é construída sobre uma redefinição do paradigma RL que leva em conta a natureza dinâmica das aplicações agênticas que requerem interação com ambientes em evolução e informações imperfeitas. Esse enquadramento é muito mais semelhante aos aplicativos do mundo real e pode ter usos importantes para tarefas de agente em ambientes empresariais.

Repensando a aprendizagem por reforço para agentes

RL tornou-se a base do treinamento de LLMs para tarefas de raciocínio bem definidas. Em áreas como matemática e codificação, o modelo recebe um sinal claro: a resposta está certa ou errada. Isso torna relativamente simples recompensar ou penalizar seu comportamento.

Mas esta abordagem enfrenta dificuldades com tarefas de agente que exigem que os modelos funcionem em ambientes interativos, desenvolvam memórias dinâmicas ao longo das conversas, executem raciocínio em várias etapas e respondam a feedback imprevisível. O treinamento de agentes com RL para esses cenários apresenta desafios únicos, especialmente em interações multivoltas, onde o projeto de recompensas eficazes é complexo e o agente treinado muitas vezes não consegue generalizar para a natureza confusa e imprevisível dos ambientes do mundo real.

Para enfrentar estes desafios, os investigadores da Universidade de Ciência e Tecnologia revisitaram o quadro fundamental da RL, conhecido como Processo de decisão de Markov (MDP). Um MDP modela a tomada de decisão usando quatro componentes principais: um espaço de estados (o conjunto de estados possíveis em que um agente pode estar); um espaço de ação (o que o agente pode fazer); uma probabilidade de transição de estado (o estado ao qual uma ação provavelmente levará); e uma função de recompensa (se o resultado é bom ou ruim). O artigo propõe estender esta estrutura para melhor atender os agentes LLM.

Na nova formulação, o espaço de estados é expandido para incluir não apenas o estado atual (a sequência atual de tokens gerados pelo modelo), mas todo o histórico de interações e feedback ambiental. As ações ainda tratam fundamentalmente da geração de texto, mas sequências específicas de texto agora podem acionar ferramentas externas, como uma chamada de API. As transições de estado tornam-se imprevisíveis, ou “estocásticas”, porque o resultado depende não apenas dos tokens que o modelo prevê, mas também da resposta do ambiente, que depende de factores externos. Finalmente, o sistema de recompensas torna-se mais granular, incorporando “recompensas de processo” intermediárias para a conclusão bem-sucedida das etapas ao longo do caminho, em vez de apenas uma única recompensa no final. Isso proporciona orientações mais frequentes e precisas ao agente durante o treinamento.

Esta última parte é especialmente importante e aborda o problema de “recompensa escassa” que a maioria das estruturas de RL enfrenta. Quando o agente recebe um único sinal de recompensa com base no resultado final, ele não aprende com as etapas intermediárias certas e erradas que tomou ao longo do caminho. As recompensas do processo resolvem esse problema fornecendo sinais de feedback nessas etapas intermediárias, tornando o processo de aprendizagem muito mais eficiente.

“Essas extensões são cruciais para permitir que algoritmos de aprendizagem por reforço treinem agentes sofisticados, capazes de raciocínio complexo e de múltiplas etapas e interação em ambientes dinâmicos”, escrevem os pesquisadores em seu artigo.

A estrutura do Agente-R1

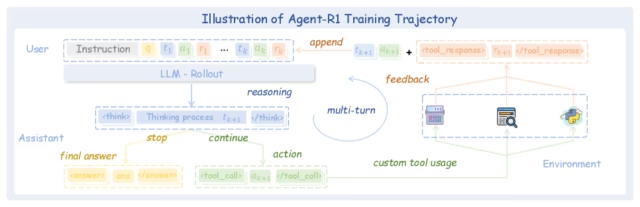

Com base na definição estendida do MDP, os pesquisadores desenvolveram Agente-R1uma plataforma de treinamento flexível e fácil de usar para agentes LLM baseados em RL. Ele estende as estruturas tradicionais de RL de turno único para lidar com a natureza interativa e multiturno das tarefas de agente, permitindo a integração perfeita com diversos ambientes.

A diferença mais significativa está na “fase de implementação”, onde o agente gera respostas. No RL de volta única, o modelo gera uma resposta uma vez. No RL multivoltas, o processo envolve uma série de interações complexas de ida e volta.

O Agent-R1 alcança essa implementação flexível de múltiplas voltas com dois módulos principais: Tool e ToolEnv. O módulo Ferramenta atua como executor de ações específicas, como chamar uma API ou acessar um banco de dados. Quando invocada, uma Ferramenta executa sua ação e retorna o resultado direto e bruto. Por outro lado, o módulo ToolEnv é o orquestrador e intérprete. Ele pega a saída da Ferramenta e determina como esse resultado afeta o estado do agente e o progresso geral da tarefa. ToolEnv gerencia transições de estado, calcula sinais de recompensa com base nos resultados da ferramenta e empacota as novas informações de estado para o agente.

Resumindo, quando uma ação é concluída, a Ferramenta relata “o que aconteceu”, enquanto o ToolEnv dita “o que esse resultado significa para o agente e para a tarefa”.

Agente-R1 em ação

Os pesquisadores testaram o Agente-R1 na desafiadora tarefa de responder perguntas em vários saltos, que requer raciocínio complexo, recuperação de informações em vários documentos e tomada de decisões em várias etapas. Eles treinaram o Qwen2.5-3B-Instruct em conjuntos de dados de controle de qualidade e avaliaram seu desempenho no HotpotQA e 2WikiMultihopQA conjuntos de dados. Eles também o testaram no conjunto de dados Musique, que estava fora do domínio das tarefas nas quais o agente foi treinado.

Eles compararam vários algoritmos RL treinados com o Agente-R1 em relação a duas linhas de base: Naive RAG, um método de recuperação de passagem única em que um LLM responde com base em um conjunto de documentos recuperados, e Base Tool Call, que usa a capacidade nativa de chamada de função do modelo sem treinamento especializado em RL.

Os resultados demonstraram que todos os agentes treinados em RL superaram substancialmente os valores iniciais. GRPO, um algoritmo RL usado em modelos de raciocínio avançados como DeepSeek-R1apresentou o melhor desempenho geral.

“Esses resultados validam de forma robusta a eficácia do Agente-R1 no treinamento de agentes LLM poderosos por meio de RL de ponta a ponta, mostrando ganhos consistentes e substanciais em relação às linhas de base em diversos conjuntos de dados e algoritmos de RL”, escrevem os pesquisadores.

Estas descobertas podem ser significativas para a empresa, onde existe um forte impulso para aplicar a RL e o raciocínio para além de domínios bem definidos. Uma estrutura projetada para lidar com interações confusas e multivoltas com usuários e ambientes dinâmicos pode abrir caminho para novos agentes capazes de resolver problemas complexos em ambientes do mundo real.

“Esperamos que o Agent-R1 forneça uma base para trabalhos futuros em treinamento de RL escalonável e unificado para LLMs de agente”, concluem os pesquisadores.